Tecnología > ANÁLISIS DE IMÁGENES

Así un experimento desvela sesgos de género en la inteligencia artificial

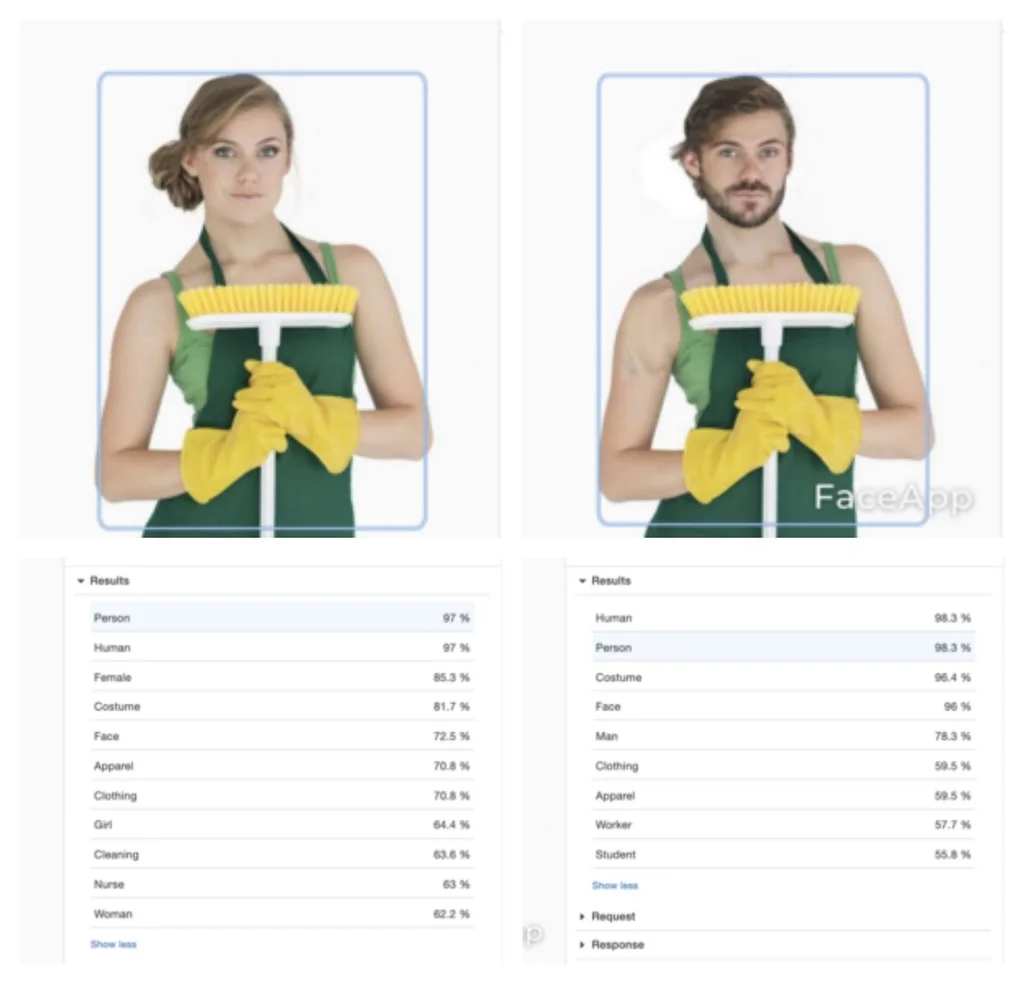

Dos imágenes prácticamente idénticas: una de ellas es la original y la otra está modificada mediante FaceApp, una aplicación de edición de fotos que genera transformaciones realistas de rostros humanos, incorporando, en este caso, elementos que socialmente se asocian al género opuesto. Ambas imágenes se insertan en algunos de los principales sistemas de reconocimiento de imágenes basados en inteligencia artificial. El resultado: la fotografía se etiqueta diferente en función del género aparente.

Esto es lo que han descubierto Ujué Agudo y Karlos G. Liberal, directora y coautor del experimento llevado a cabo en el laboratorio de la consultora Biko. “Nos lanzamos a analizar con Amazon Rekognition e ImageNet fotografías de personas que portaban objetos históricamente estereotipados, contrastando los resultados con los 'dobles' de estas fotografías con el género aparente de éstas cambiado. Nuestro objetivo era que la comparación se realizara entre fotografías lo más similares posibles”, explica la directora en un artículo para Medium.

Estos programas realizan un reconocimiento de imágenes. En cada caso, analiza los objetos que aparecen en ellas como rasgos faciales, emociones, rango de edad, género. Tras el análisis de cada foto, el sistema arroja un porcentaje de fiabilidad de lo que puede aparecer allí.

En la fotografía original (la de la izquierda) el objeto se confunde con un secador, mientras que en la modificada (la de la derecha) no. Esto mismo ocurre con decenas de imágenes parecidas, donde los programas llegan a confundir las herramientas portadas por mujeres con un producto de limpieza, una banana, un celular, una tabla de snow, una maleta, o directamente, no reconoce el objeto.

A la inversa ocurre lo mismo. En la fotografía original (la de la izquierda) los sistemas reconocen el objeto de limpieza, mientras que en la modificada (la de la derecha), al entender los sistemas que el protagonista es un hombre, confunden la escoba con una raqueta o un friesbee.

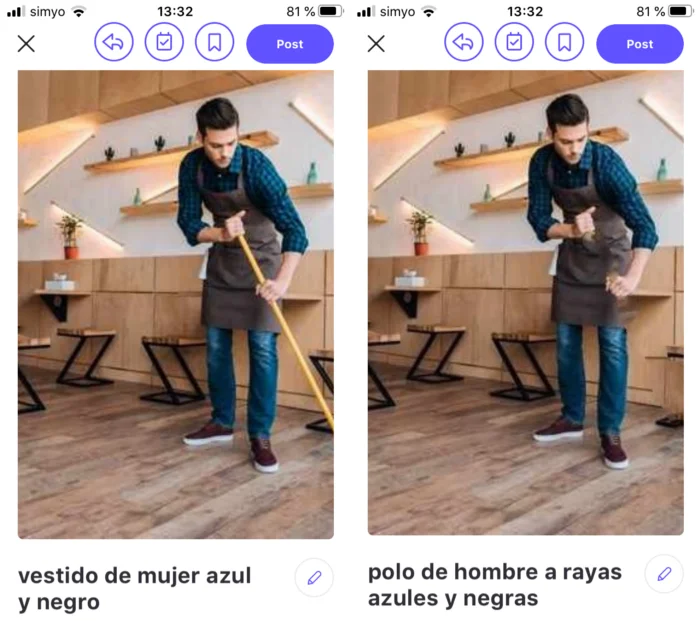

Explica la directora del experimento que la alerta acerca de este género saltó cuando, mientras jugaban con una app para el sector de shopping denominada CamFind, descubrieron que al eliminar un objeto de una fotografía la descripción cambiaba significativamente. Para la fotografía en la que aparece una escoba el sistema identificaba un “vestido de mujer azul y negro”, mientras que para la misma fotografía en la que no aparecía la escoba el sistema devolvía la descripción “polo de hombre a rayas azules y negras”.

“De un tiempo a esta parte, a pesar de la fe puesta en los supuestos superpoderes de la inteligencia artificial, hemos tenido que asumir que ni es tan objetiva ni tan neutral como se deseaba creer. En muchas ocasiones es ineficaz, discriminatoria, sexista y racista”, afirma la directora.

Si pareces mujer, la tecnología de reconocimiento de imágenes no identificará un taladro en tu mano. O confundirá tu martillo con un secador. Pero no ocurrirá así si pareces un hombre. Una prueba más del sexismo en la inteligencia artificial @biko2 + #bikolabs pic.twitter.com/wyzVW360cv

— ujue agudo (@ujue) July 2, 2020